- Код: Выделить всё

User-Agent: *

Host: example.com

Disallow: /forum/adm

Disallow: /forum/cache

Disallow: /forum/classes

Disallow: /forum/docs

Disallow: /forum/download

Allow: /forum/download/file.php

Disallow: /forum/files

Disallow: /forum/includes

Disallow: /forum/install

Disallow: /forum/language

Disallow: /forum/stk

Disallow: /forum/store

Disallow: /forum/mcp.php

Disallow: /forum/posting.php

Disallow: /forum/report.php

Disallow: /forum/viewtopic.php?*&view=print

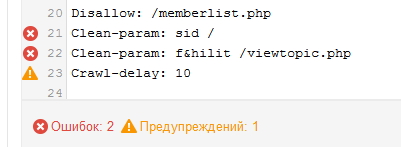

Disallow: /forum/memberlist.php

Clean-param: sid /forum/

Clean-param: f&hilit /forum/viewtopic.php

Crawl-delay: 10

По сравнению с файлом robots.txt phpBBex 1.х убраны строки

- Код: Выделить всё

Disallow: /forum/modules

Disallow: /forum/styles

Disallow: /forum/umil

Disallow: /forum/style.php

Настоятельно рекомендую проверить наличие данных строк и удалить. Например, строка

Disallow: /forum/styles запрещает индексирование файлов стилей, вследствие чего поисковые роботы не смогут определить наличие адаптивного дизайна, и понизят позиции в выдаче для мобильных устройств.Внимание! Перед использованием вы должны:

1. Заменить адрес в директиве Host, причём важно указать основную форму домена (с www или без)

2. Заменить путь «/forum/» на ваш, если у вас форум в корне — замените просто на «/»

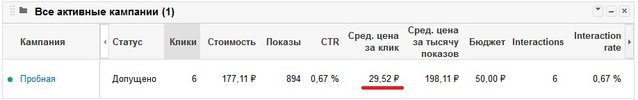

у яндекса сколько?

у яндекса сколько?